3279 阅读 2020-10-13 10:22:03 上传

以下文章来源于 语言学探索

首先来看计算机视觉论文:

- 图神经网络(GNNs)将神经网络从规则结构的应用推广到任意图形的应用,并在计算机视觉、社会网络和化学等许多应用领域取得了成功。[1]沿着两个方向扩展GNN:1)允许每个节点的特征用二维空间置信映射来表示,而不是用一维向量来表示;2)提出了一种有效的操作,通过在每条边上使用不同的可学习核的二维卷积来整合邻近节点的信息。文章提出的SIA-GCN可以有效地从每个节点的二维地图中提取空间信息,并通过图的卷积进行传播。通过将每条边与指定的卷积核相关联,SIA-GCN可以捕获不同对相邻节点的不同空间关系。文章演示了SIA-GCN在从单帧图像中估计手部关键点上的结果,其中节点表示关键点的2D坐标热图,而边表示关键点之间的动力学关系。在多个数据集上的实验结果表明,文章提出的算法提供了一个灵活而强大的框架来考虑关键点之间的结构约束,在手部姿态估计任务中可以达到最先进的性能。

自然语言处理方面:

- 文本蕴涵,即确定一段文本是否在逻辑上跟随另一段文本的任务,是NLP中的一个关键组件,它为例如问答、文本摘要、信息提取和机器翻译等许多语义应用程序提供输入。文本蕴含任务所包含的场景范围可以从简单的语法变化到文本片段之间更复杂的语义关系,但大多数方法都尝试一劳永逸的解决方案,这种解决方案通常倾向于某些场景,而不利于另一些场景。此外,对于需要世界知识的蕴含任务,大多数系统仍然作为一个黑盒模型进行工作,提供一个是或否的答案,但不能解释潜在的推理过程。[21]引入XTE-可解释文本蕴涵——这是一种新的识别文本蕴涵的复合方法,它通过分析蕴涵对来决定从句法还是语义上解决问题。此外,文章提出的方法可以使答案具有可解释性,文章使用由结构化词汇定义组成的外部知识库来生成自然语言理由,以解释文本片段之间的语义关系。除了性能优于已建立的文本蕴含算法之外,文章提出的复合方法向可解释的人工智能迈出了重要一步,允许推理模型解释,使语义推理过程显式和可理解。

- 生成常识推理是文本生成的一个关键瓶颈,其目的是让机器生成具有对一组概念进行推理能力的句子。即使是最先进的预训练语言生成模型在这个任务上也很困难,经常会产生难以置信和反常的句子。一个原因是他们很少考虑合并知识图谱,而合并知识图谱能在常识概念中提供丰富的关系信息。为了提高文本生成的常识推理能力,[19]提出了一种新的知识图谱化预训练语言生成模型KG-BART,该模型通过知识图谱来包含概念之间的复杂关系,并生成更符合逻辑、更自然的句子作为输出。此外,KG-BART可以利用图的注意力来聚合丰富的概念语义,从而增强模型在未见的概念集上的泛化。在基准的CommonGen数据集上进行的实验验证了文章提出的方法的有效性,并与几个预先训练好的语言生成模型进行了比较,特别是在BLEU-3、4方面,KG-BART比BART的性能要高15.98%、17.49%。此外,文章还展示了由其提出的模型生成的上下文可以作为后台场景使用,从而有利于下游的常识QA任务。

- 这是一篇来自微软与北大的联合研究。[15]专注于程序文本理解(procedural text understanding)任务,该任务旨在在自然过程中跟踪实体的状态和位置。尽管近期方法已取得实质性进展,但是它们远落后于人类成绩。常识推理之难和数据不足,这两个挑战仍没有解决。基于此,研究者提出一种新的考虑知识的程序文本理解(KnOwledge-Aware proceduraL text understAnding, KOALA)模型,该模型利用外部知识源来解决这些问题。具体而言,从ConceptNet检索信息丰富的知识三元组,并在跟踪实体的同时执行知识感知推理。此外,研究者采用一个多阶训练模式,该模式可以根据从维基百科收集的未标注数据对BERT模型进行微调,然后再在最终模型上对其进行微调。在两个程序文本数据集ProPara和Recipes上的实验结果验证了所提方法的有效性。与各种基准相比,KOALA具有最先进的性能。

- 这是一项来自北大和阿里的联合研究。长文本生成是一项重要但具有挑战的任务。主要问题在于学习传统生成模型经常遭受的句子级语义依赖。为解决此问题,[13]提出一种多跳推理生成(Multi-hop Reasoning Generation,MRG)方法,该方法在知识图谱上结合多跳推理以学习句子间的语义依赖性。MRG由两部分组成,一个是基于图的多跳推理模块,另一个是路径感知语句实现模块。推理模块负责从知识图谱中搜索主干路径,以模仿人类写作中的想象力过程以进行语义转换。基于推断的路径,句子实现模块随后生成完整句子。与以前的黑匣子模型不同,MRG明确推断出主干路径,该路径提供了解释性的视图以了解所提模型如何工作。研究者对三个具有代表性的任务进行实验,包括故事生成、评论生成和产品描述生成。自动和手动评估表明,所提方法比诸如训练有素的模型(例如GPT-2)和知识增强模型之类的强基准可以生成更多的信息和连贯的长文本。

- 在基于检索的多轮对话建模中,如何根据上下文话语中显著特征的提取来选择最合适的应答仍然是一个难题。随着对话的进行,通过连续的多轮对话语境,会话层面的话题转换自然发生。然而,所有已知的基于检索的系统都只满足于利用局部主题词进行语境话语表征,而不能在话语层面捕捉到这类必要的全局主题意识线索。[24]提出了一种新颖的topic-aware多轮对话解决方案,该方法以无监督的方式对话题感知话语进行分段和提取,使模型能够捕捉到需要的话语层面的显著话题转移,从而有效地跟踪多回合对话中的话题流。文章提出的主题感知模型是通过一种新提出的无监督主题感知分割算法和主题感知双注意匹配(TADAM)网络实现的,该网络以双交叉注意的方式匹配每个主题片段和响应。在三个公共数据集上的实验结果表明,TADAM在很大程度上优于最先进的方法,特别是在主题有明显变化的电子商务数据集上,比最先进的方法提升了3.4%

- 这是一项来自Facebook和爱丁堡大学的联合研究。Transformer模型在许多序列建模任务中都达到了最先进性能。但是,如何利用较大或可变深度的模型容量仍是一个挑战。[14]提出一个概率框架,通过学习层选择的后验分布来自动学习要使用哪个层。作为此框架的扩展,研究者提出一种新方法来训练一个共享Transformer网络,用于多语言机器翻译,每个语言对(language pair)具有不同的层级选择后代。所提方法减轻了梯度消失问题,并能稳定训练深层Transformer(例如100层)。研究者在WMT英语-德语机器翻译和掩码语言建模任务上进行评估,所提方法优于训练了更深层的Transformer现有方法。多语言机器翻译实验表明,这种方法可以有效利用增加的模型容量,并为使用多种语言对的多对一和一对多翻译带来普遍提升。

- 这是一篇来自AWS AI(亚马逊)的研究。[16]提出一种用于联合序列标注和句子级分类的生成框架。该模型使用单个共享自然语言输出空间一次执行多个序列标注任务。与以前的判别方法不同,该模型自然包含了标签语义,并跨任务共享知识。该框架是通用的,可以在少量、低资源和高资源任务上执行良好。研究者在流行的命名实体识别、槽标签和意图分类基准上展示了这些优势。为少次槽标签任务设置了新的最佳技术基线,与之前的5次(75.0%→ 90.9%)和1次(70.4%→81.0%)学习取得最新结果。此外,该模型通过结合标签语义,在BERT基线上的低资源槽标签任务上产生巨大提升(46.27%→63.83%)。研究者还在高资源任务上保持竞争性结果,并在SNIPS数据集上达到了新的最佳水平。

- 基于远程监督的n元交叉句关系提取模型假设提及n个实体的连续句描述了这n个实体之间的关系。然而,一方面,这种假设引入了有噪声的标签数据,从而影响了模型的性能。另一方面,一些非连续句也描述了一种关系,在这种假设下这些句子不能被标记出来。[22]通过一个较弱的远程监督假设来放松这个强假设来解决第二个问题,并提出一个新的句子分布估计器模型来解决第一个问题。该估计器选择正确标记的句子来缓解数据噪声的影响,是一种两级代理强化学习模型。此外,文章还提出了一种混合了注意机制和PCNN的通用关系提取器,使其可以部署在任何任务中,包括连续句子和非连续句子。实验表明,与基线模型相比,该模型能够降低数据噪声的影响,在一般n元交叉句关系提取任务中取得了更好的性能。

- 话题漂移是多轮对话中常见的一种现象。因此,理想的对话生成模型应该能够捕获每个上下文的主题信息,检测相关的上下文,并相应地生成适当的响应。但是,现有的模型通常使用词或句子层次的相似性来检测相关语境,不能很好地捕捉主题层次的相关性。[17]提出了一个新的模型STAR-BTM来解决这个问题。文章首先在整个训练数据集上对Biterm Topic Model进行预训练。然后,根据上下文的主题表示,计算出主题层次的注意力权值。最后,在解码过程中利用注意力权重和话题分布来生成相应的响应。在中国客户服务数据和英语Ubuntu对话数据上的实验结果表明,STAR-BTM在基于度量和人工评估方面都明显优于几种最新的方法。

- 在自然语言处理(NLP)中,最近已显示了迁移到下游任务的预训练语言模型(LM)可实现当前最佳结果。[23]通过引入新的正则化技术AFTER来扩展预训练LM的标准微调过程。以域对抗性微调作为有效的调节器。具体而言,用对抗性目标来补充微调过程中使用的特定于任务的损失。此额外的损失项与对抗分类器有关,该分类器旨在区分域内和域外文本表示形式。域内是指当前任务的标注数据集,而域外是指来自不同域的未标注数据集。直观上,对抗分类器充当正则化项,可防止模型过拟合到特定于任务的域。关于情感分析、语言可接受性和复述检测的经验结果表明,与标准微调相比,AFTER可以提高性能。

- [20]提出一种简单有效的多跳密集检索方法来回答复杂的开放域问题,该方法可在两个多跳数据集HotpotQA和多证据FEVER上实现最先进性能。与现有工作相反,所提方法不需要访问任何特定语料信息(例如文档间超链接或带有人工标注的实体标记),且可以应用于任何非结构化文本语料。该系统还产生了更好的效率-精度的折衷,与HotpotQA上已发布的最佳精度相当,而推理时间却快了10倍。

- 讽刺检测是情感计算中的重要任务,需要大量标注数据。[18]介绍反应监督(reactive supervision),一种新数据收集方法,利用在线对话的动态性来克服现有数据收集技术的局限。研究者使用新方法来创建和发布带讽刺视角标签和新上下文特征的首个大型推特文本数据集。该数据集有望促进讽刺检测研究。所提方法可以适应其他情感计算领域,从而开辟了新的研究机会。

除此之外,本期还有如下看点:

- 对抗性训练,即在对抗性和干净的例子上训练网络,是抵御对抗性攻击最可信的防御方法之一。然而,在实现和部署这种方法时有三个主要的实际困难:1、运行内存和计算成本昂贵;2、干净的和敌对的例子之间的准确性权衡;3、不能在训练时预知所有的对手攻击。[51]提出了一个有益扰动网络(Beneficial perturbation Networks,BPN)模型,以减轻这三个困难所带来的影响。BPN产生并利用有益的扰动(与众所周知的对抗性扰动有些相反)作为网络参数空间内的偏差,以中和对抗性扰动对数据样本的影响。因此,BPN可以有效地抵御对抗性实例。与对抗训练相比,文章证明了BPN可以显著减少所需的运行内存和计算成本,通过循环利用在干净示例上训练得到的梯度产生有益的扰动。此外,BPN通过中和敌对和有益扰动,增加了训练集的多样性,从而提高了网络的泛化程度,缓解了精确度权衡的困难和预测多重攻击的困难。

- [50]发现流行的少次学习(FSL)方法中一个经常被忽视的缺陷:预训练知识限制了性能。这一发现源于研究者的因果假设:一个结构因果模型(Structural Causal Model ,SCM),用于预训练知识、样本特征和标签间的因果关系。基于该模型,研究者提出一种新FSL范式:介入式少次学习(Interventional Few-Shot Learning,IFSL)。具体而言,研究者基于后门调整开发了三种有效的IFSL算法实现,实际上是对多次学习SCM的因果干预:即因果关系中FSL的上界。值得注意的是,IFSL的作用与现有基于微调和基于元学习的FSL方法正交,因此IFSL可以改进所有这些方法,从而实现了新的1- 5轮次学习技术。

- 这是一项来自华为诺亚方舟实验室的研究。像BERT这样基于Transformer的预训练模型在许多自然语言处理任务中都取得了卓越的性能,但是这些模型在计算和内存上都很昂贵,从而阻碍了它们在资源受限的设备中的部署。[74]提出TernaryBERT,可以在经过微调的BERT模型中进行权重化(ternarizes the weights)。具体而言,研究者同时使用基于近似和损失感知的分层方法,并根据经验研究BERT不同部分的分层粒度。此外,为减少由于低位容量不足而导致的精度下降,在训练过程中利用了知识蒸馏技术。在GLUE基准测试和SQuAD上进行的实验表明,TernaryBERT优于其他BERT量化方法,甚至可以达到与全精度模型相当的性能,但尺寸要小14.9倍。

- [100]提出一个端到端深度模型,用于野外说话者识别。该模型使用Thin-ResNet从话语中提取说话人嵌入,并使用孪生胶囊网络和动态路由作为后端来计算嵌入之间的相似度得分。研究者对模型与最新解决方案进行一系列实验和比较,表明所提模型在使用大量训练数据的情况下胜过所有其他模型。研究者还将执行其他实验,以研究不同说话人嵌入对孪生胶囊网络的影响。实验表明,通过使用直接从前端的特征聚合模块获得的嵌入,并使用动态路由将其传递到更高的封装,可以达到最佳性能。

- 开放域问答(OpenQA)任务近来已引起自然语言处理(NLP)社区越来越多的关注。[116]展示从专业医学委员会考试中收集的第一个自由格式的多项选择开放问答数据集MedQA,用于解决医学问题。其涵盖三种语言:英语、简体中文和繁体中文,分别包含三种语言的12,723、34,251和14,123个问题。研究者通过顺序组合文档检索器和机器阅读理解模型来实现基于规则和流行的神经方法。通过实验,研究者发现即使是目前最好的方法,在英语、繁体中文和简体中文问题上也只能分别达到36.7%,42.0%和70.1%的测试准确性。研究者希望MedQA对现有OpenQA系统提出巨大挑战,并希望其可作为一个平台,将来在NLP社区中推广更强大的OpenQA模型。

最后,本期还包含3个新构造的数据集[44-46],3个新出现的挑战赛[47-49],11篇综述[86-96],3个开放平台或工具包[97-99],以及其他技术。

计算机视觉

Computer Vision

[1]

SIA-GCN: A Spatial Information Aware Graph Neural Network with 2D Convolutions for Hand Pose Estimation

Deying Kong, Haoyu Ma, Xiaohui Xie

摘 要:

原 文:http://arxiv.org/pdf/2009.12473v1

[2]

Causal Intervention for Weakly-Supervised Semantic Segmentation

Dong Zhang, Hanwang Zhang, Jinhui Tang, Xiansheng Hua, Qianru Sun

摘 要:

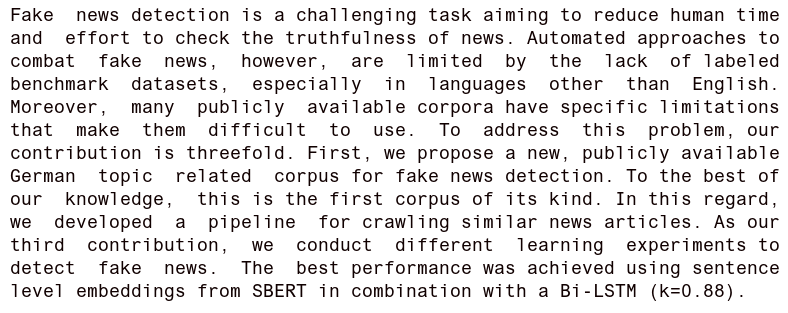

原 文:http://arxiv.org/pdf/2009.12547v1

资 源:github.com/ZHANGDONG-NJUST/CONTA

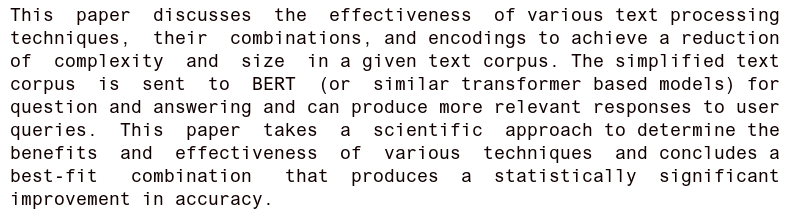

[3]

An Easy-to-use Real-world Multi-objective Optimization Problem Suite

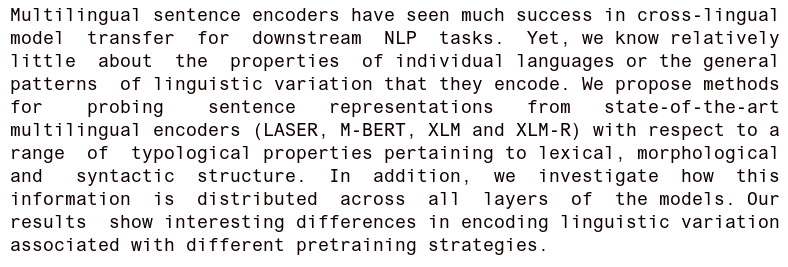

Ryoji Tanabe, Hisao Ishibuchi

摘 要:

原 文:http://arxiv.org/pdf/2009.12867v1

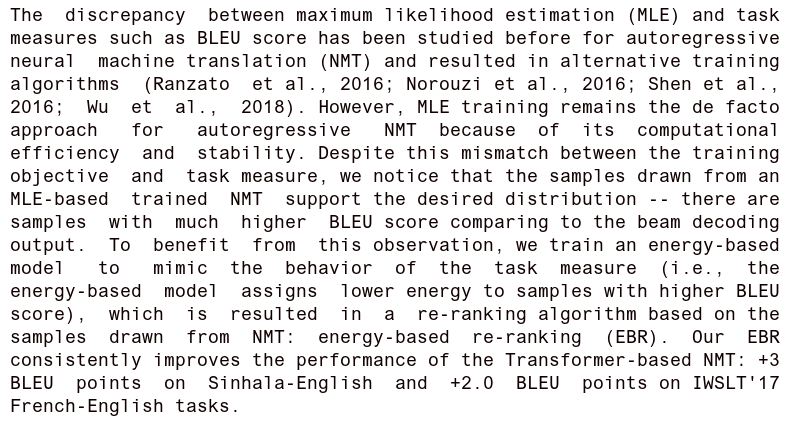

资 源:github.com/ryojitanabe/reproblems

[4]

Learning to Improve Image Compression without Changing the Standard Decoder

Yannick Strümpler, Ren Yang, Radu Timofte

摘 要:

原 文:http://arxiv.org/pdf/2009.12927v1

[5]

Learning to Adapt Multi-View Stereo by Self-Supervision

Arijit Mallick, Jörg Stückler, Hendrik Lensch

摘 要:

原 文:http://arxiv.org/pdf/2009.13278v1

[6]

Distribution Matching for Crowd Counting

Boyu Wang, Huidong Liu, Dimitris Samaras, Minh Hoai

摘 要:

原 文:http://arxiv.org/pdf/2009.13077v1

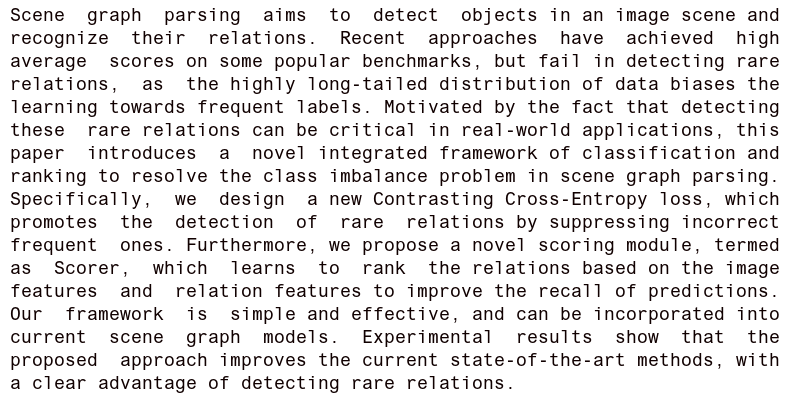

资 源:github.com/cvlab-stonybrook/DM-Count

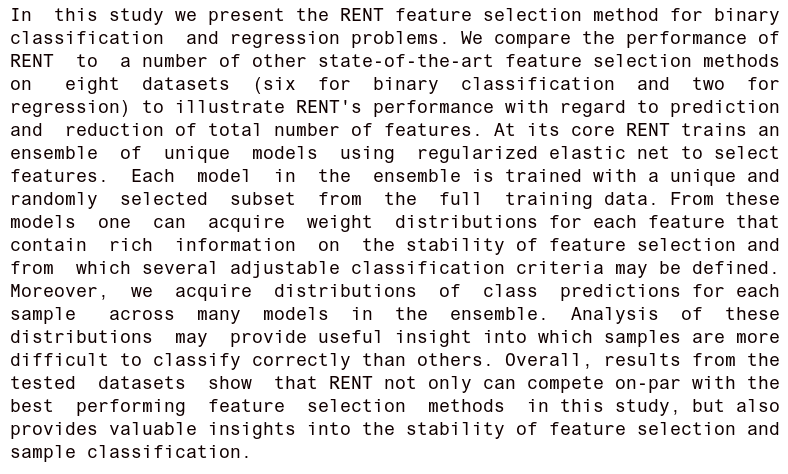

[7]

Using Resource-Rational Analysis to Understand Cognitive Biases inInteractive Data Visualizations

Ryan Wesslen, Doug Markant, Alireza Karduni, Wenwen Dou

摘 要:

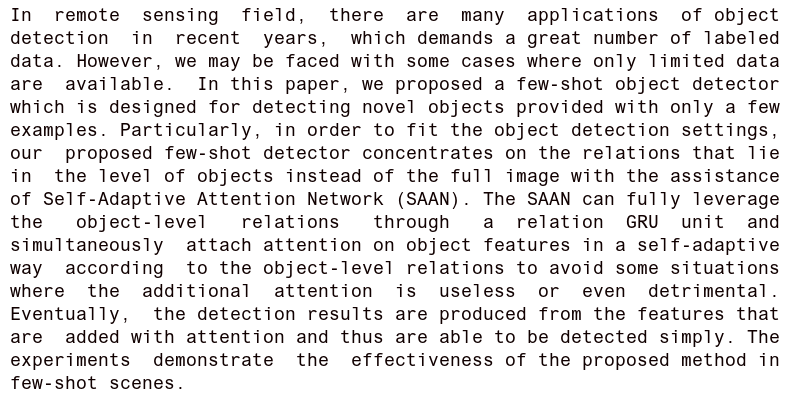

原 文:http://arxiv.org/pdf/2009.13368v1

[8]

Learning Self-Expression Metrics for Scalable and Inductive Subspace Clustering

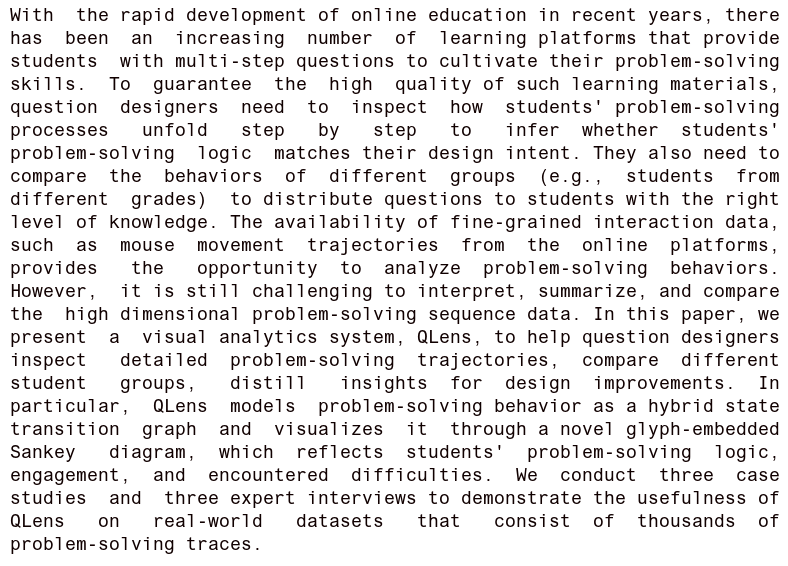

Julian Busch, Evgeniy Faerman, Matthias Schubert, Thomas Seidl

摘 要:

原 文:http://arxiv.org/pdf/2009.12875v1

资 源:github.com/buschju/sscn

[9]

Process mining classification with a weightless neural network

Rafael Garcia Barbastefano, Maria Clara Lippi, Diego Carvalho

摘 要:

原 文:http://arxiv.org/pdf/2009.12416v1

[10]

Learning Category- and Instance-Aware Pixel Embedding for Fast Panoptic Segmentation

Naiyu Gao, Yanhu Shan, Xin Zhao, Kaiqi Huang

摘 要:

原 文:http://arxiv.org/pdf/2009.13342v1

[11]

A Study on Lip Localization Techniques used for Lip reading from a Video

S. D. Lalitha, K. K. Thyagharajan

摘 要:

原 文:http://arxiv.org/pdf/2009.13420v1

[12]

ConvSequential-SLAM: A Sequence-based, Training-less Visual Place Recognition Technique for Changing Environments

Mihnea-Alexandru Tomită, Mubariz Zaffar, Michael Milford, Klaus McDonald-Maier, Shoaib Ehsan

摘 要:

原 文:http://arxiv.org/pdf/2009.13454v1

自然语言处理

Natural Language Processing

[13]

Graph-based Multi-hop Reasoning for Long Text Generation

Liang Zhao, Jingjing Xu, Junyang Lin, Yichang Zhang, Hongxia Yang, Xu Sun

摘 要:

原 文:http://arxiv.org/pdf/2009.13282v1

[14]

Deep Transformers with Latent Depth

Xian Li, Asa Cooper Stickland, Yuqing Tang, Xiang Kong

摘 要:

原 文:http://arxiv.org/pdf/2009.13102v1

[15]

Knowledge-Aware Procedural Text Understanding with Multi-Stage Training

Zhihan Zhang, Xiubo Geng, Tao Qin, Yunfang Wu, Daxin Jiang

摘 要:

原 文:http://arxiv.org/pdf/2009.13199v1

资 源:github.com/allenai/propara

[16]

Augmented Natural Language for Generative Sequence Labeling

Ben Athiwaratkun, Cicero Nogueira dos Santos, Jason Krone, Bing Xiang

摘 要:

原 文:http://arxiv.org/pdf/2009.13272v1

[17]

Modeling Topical Relevance for Multi-Turn Dialogue Generation

Hainan Zhang, Yanyan Lan, Liang Pang, Hongshen Chen, Zhuoye Ding, Dawei Yin

摘 要:

原 文:http://arxiv.org/pdf/2009.12735v1

资 源:github.com/rkadlec/ubuntu-ranking-dataset-creator

[18]

Reactive Supervision: A New Method for Collecting Sarcasm Data

Boaz Shmueli, Lun-Wei Ku, Soumya Ray

摘 要:

原 文:http://arxiv.org/pdf/2009.13080v1

[19]

KG-BART: Knowledge Graph-Augmented BART for Generative Commonsense Reasoning

Ye Liu, Yao Wan, Lifang He, Hao Peng, Philip S. Yu

摘 要:

原 文:http://arxiv.org/pdf/2009.12677v1

资 源:github.com/huggingface/transformers, github.com/commonsense/conceptnet5, github.com/thunlp/OpenKE, github.com/yeliu918/KG-BART

[20]

Answering Complex Open-Domain Questions with Multi-Hop Dense Retrieval

Wenhan Xiong, Xiang Lorraine Li, Srini Iyer, Jingfei Du, Patrick Lewis, William Yang Wang, Yashar Mehdad, Wen-tau Yih, Sebastian Riedel, Douwe Kiela, Barlas Oğuz

摘 要:

原 文:http://arxiv.org/pdf/2009.12756v1

[21]

XTE: Explainable Text Entailment

Vivian S. Silva, André Freitas, Siegfried Handschuh

摘 要:

原 文:http://arxiv.org/pdf/2009.12431v1

[22]

Reinforcement Learning-based N-ary Cross-Sentence Relation Extraction

Chenhan Yuan, Ryan Rossi, Andrew Katz, Hoda Eldardiry

摘 要:

原 文:http://arxiv.org/pdf/2009.12683v1

[23]

Domain Adversarial Fine-Tuning as an Effective Regularizer

Giorgos Vernikos, Katerina Margatina, Alexandra Chronopoulou, Ion Androutsopoulos

摘 要:

原 文:http://arxiv.org/pdf/2009.13366v1

[24]

Topic-Aware Multi-turn Dialogue Modeling

Yi Xu, Hai Zhao, Zhuosheng Zhang

摘 要:

原 文:http://arxiv.org/pdf/2009.12539v1

资 源:github.com/huggingface/transformers

[25]

Learning to Plan and Realize Separately for Open-Ended Dialogue Systems

Sashank Santhanam, Zhuo Cheng, Brodie Mather, Bonnie Dorr, Archna Bhatia, Bryanna Hebenstreit, Alan Zemel, Adam Dalton, Tomek Strzalkowski, Samira Shaikh

摘 要:

原 文:http://arxiv.org/pdf/2009.12506v1

资 源:github.com/sashank06/

planning_generation

[26]

iNLTK: Natural Language Toolkit for Indic Languages

Gaurav Arora

摘 要:

原 文:http://arxiv.org/pdf/2009.12534v1

资 源:github.com/attardi/wikiextractor, github.com/goru001/inltk, github.com/fastai/fastai, github.com/goru001/inltk#inltks-appreciation

[27]

Visually Grounded Compound PCFGs

Yanpeng Zhao, Ivan Titov

摘 要:

原 文:http://arxiv.org/pdf/2009.12404v1

[28]

Reducing Quantity Hallucinations in Abstractive Summarization

Zheng Zhao, Shay B. Cohen, Bonnie Webber

摘 要:

原 文:http://arxiv.org/pdf/2009.13312v1

[29]

Group Whitening: Balancing Learning Efficiency and Representational Capacity

Lei Huang, Li Liu, Fan Zhu, Ling Shao

摘 要:

原 文:http://arxiv.org/pdf/2009.13333v1

资 源:github.com/facebookresearch/maskrcnn-benchmark

[30]

Learning to Stop: A Simple yet Effective Approach to Urban Vision-Language Navigation

Jiannan Xiang, Xin Eric Wang, William Yang Wang

摘 要:

原 文:http://arxiv.org/pdf/2009.13112v1

资 源:github.com/lil-lab/touchdown

[31]

Unsupervised Pre-training for Biomedical Question Answering

Vaishnavi Kommaraju, Karthick Gunasekaran, Kun Li, Trapit Bansal, Andrew McCallum, Ivana Williams, Ana-Maria Istrate

摘 要:

原 文:http://arxiv.org/pdf/2009.12952v1

[32]

Hierarchical Sparse Variational Autoencoder for Text Encoding

Victor Prokhorov, Yingzhen Li, Ehsan Shareghi, Nigel Collier

摘 要:

原 文:http://arxiv.org/pdf/2009.12421v1

资 源:github.com/jxhe/vae-lagging-encoder, github.com/srhrshr/torchDatasets

[33]

Generative latent neural models for automatic word alignment

Anh Khoa Ngo Ho, François Yvon

摘 要:

原 文:http://arxiv.org/pdf/2009.13117v1

资 源:github.com/moses-smt/mosesdecoder

[34]

A Diagnostic Study of Explainability Techniques for Text Classification

Pepa Atanasova, Jakob Grue Simonsen, Christina Lioma, Isabelle Augenstein

摘 要:

原 文:http://arxiv.org/pdf/2009.13295v1

资 源:github.com/copenlu/xai-benchmark

[35]

Similarity Detection Pipeline for Crawling a Topic Related Fake News Corpus

Inna Vogel, Jeong-Eun Choi, Meghana Meghana

摘 要:

原 文:http://arxiv.org/pdf/2009.13367v1

资 源:github.com/dbmdz/berts

[36]

Towards a Natural Language Query Processing System

Chantal Montgomery, Haruna Isah, Farhana Zulkernine

摘 要:

原 文:http://arxiv.org/pdf/2009.12414v1

[37]

Techniques to Improve Q&A Accuracy with Transformer-based models on Large Complex Documents

Chejui Liao, Tabish Maniar, Sravanajyothi N, Anantha Sharma

摘 要:

原 文:http://arxiv.org/pdf/2009.12695v1

[38]

Multi-timescale representation learning in LSTM Language Models

Shivangi Mahto, Vy A. Vo, Javier S. Turek, Alexander G. Huth

摘 要:

原 文:http://arxiv.org/pdf/2009.12727v1

[39]

What does it mean to be language-agnostic? Probing multilingual sentence encoders for typological properties

Rochelle Choenni, Ekaterina Shutova

摘 要:

原 文:http://arxiv.org/pdf/2009.12862v1

[40]

SPARTA: Efficient Open-Domain Question Answering via Sparse Transformer Matching Retrieval

Tiancheng Zhao, Xiaopeng Lu, Kyusong Lee

摘 要:

原 文:http://arxiv.org/pdf/2009.13013v1

[41]

Neural Baselines for Word Alignment

Anh Khoa Ngo Ho, François Yvon

摘 要:

原 文:http://arxiv.org/pdf/2009.13116v1

[42]

Energy-Based Reranking: Improving Neural Machine Translation Using Energy-Based Models

Subhajit Naskar, Amirmohammad Rooshenas, Simeng Sun, Mohit Iyyer, Andrew McCallum

摘 要:

原 文:http://arxiv.org/pdf/2009.13267v1

[43]

Zero-shot Multi-Domain Dialog State Tracking Using Descriptive Rules

Edgar Altszyler, Pablo Brusco, Nikoletta Basiou, John Byrnes, Dimitra Vergyri

摘 要:

原 文:http://arxiv.org/pdf/2009.13275v1

数据集

Dataset

[44]

Afro-MNIST: Synthetic generation of MNIST-style datasets for low-resource languages

Daniel J Wu, Andrew C Yang, Vinay U Prabhu

摘 要:

原 文:http://arxiv.org/pdf/2009.13509v1

资 源:github.com/Daniel-Wu/AfroMNIST

[45]

DWIE: an entity-centric dataset for multi-task document-level information extraction

Klim Zaporojets, Johannes Deleu, Chris Develder, Thomas Demeester

摘 要:

原 文:http://arxiv.org/pdf/2009.12626v1

资 源:github.com/klimzaporojets/DWIE, github.com/conll/reference-coreference-scorers

[46]

Pchatbot: A Large-Scale Dataset for Personalized Chatbot

Xiaohe Li, Hanxun Zhong, Yu Guo, Yueyuan Ma, Hongjin Qian, Zhanliang Liu, Zhicheng Dou, Ji-Rong Wen

摘 要:

原 文:http://arxiv.org/pdf/2009.13284v1

竞赛与挑战

Competition & Challenge

[47]

AIM 2020 Challenge on Video Temporal Super-Resolution

Sanghyun Son, Jaerin Lee, Seungjun Nah, Radu Timofte, Kyoung Mu Lee

摘 要:

原 文:http://arxiv.org/pdf/2009.12987v1

[48]

Fancy Man Lauches Zippo at WNUT 2020 Shared Task-1: A Bert Case Model for Wet Lab Entity Extraction

Haoding Meng, Qingcheng Zeng, Xiaoyang Fang, Zhexin Liang

摘 要:

原 文:http://arxiv.org/pdf/2009.12997v1

[49]

AIM 2020: Scene Relighting and Illumination Estimation Challenge

Majed El Helou, Ruofan Zhou, Sabine Süsstrunk, Radu Timofte, Mahmoud Afifi, Michael S. Brown, Kele Xu, Hengxing Cai, Yuzhong Liu, Li-Wen Wang, Zhi-Song Liu, Chu-Tak Li, Sourya Dipta Das, Nisarg A. Shah, Akashdeep Jassal, Tongtong Zhao, Shanshan Zhao, Sabari Nathan, M. Parisa Beham, R. Suganya, Qing Wang, Zhongyun Hu, Xin Huang, Yaning Li, Maitreya Suin

摘 要:

原 文:http://arxiv.org/pdf/2009.12798v1

资 源:github.com/mahmoudnafifi/

image_relighting,

github.com/majedelhelou/VIDIT

方法论

Methodology

[50]

Interventional Few-Shot Learning

Zhongqi Yue, Hanwang Zhang, Qianru Sun, Xian-Sheng Hua

摘 要:

原 文:http://arxiv.org/pdf/2009.13000v1

资 源:github.com/deepmind/leo, github.com/hushell/sib_meta_learn, github.com/wyharveychen/CloserLookFewShot, github.com/facebookresearch/detectron, github.com/yaoyao-liu/meta-transfer-learning

[51]

Beneficial Perturbations Network for Defending Adversarial Examples

Shixian Wen, Laurent Itti

摘 要:

原 文:http://arxiv.org/pdf/2009.12724v1

[52]

Learning Optimal Representations with the Decodable Information Bottleneck

Yann Dubois, Douwe Kiela, David J. Schwab, Ramakrishna Vedantam

摘 要:

原 文:http://arxiv.org/pdf/2009.12789v1

资 源:github.com/YannDubs/Overlayed-Datasets

[53]

Long-Tailed Classification by Keeping the Good and Removing the Bad Momentum Causal Effect

Kaihua Tang, Jianqiang Huang, Hanwang Zhang

摘 要:

原 文:http://arxiv.org/pdf/2009.12991v1

资 源:github.com/KaihuaTang/Long-Tailed-Recognition.pytorch

[54]

Benchmarking deep inverse models over time, and the neural-adjoint method

Simiao Ren, Willie Padilla, Jordan Malof

摘 要:

原 文:http://arxiv.org/pdf/2009.12919v1

[55]

EvolGAN: Evolutionary Generative Adversarial Networks

Baptiste Roziere, Fabien Teytaud, Vlad Hosu, Hanhe Lin, Jeremy Rapin, Mariia Zameshina, Olivier Teytaud

摘 要:

原 文:http://arxiv.org/pdf/2009.13311v1

资 源:github.com/moxiegushi/pokeGAN

[56]

Driver Drowsiness Classification Based on Eye Blink and Head Movement Features Using the k-NN Algorithm

Mariella Dreissig, Mohamed Hedi Baccour, Tim Schaeck, Enkelejda Kasneci

摘 要:

原 文:http://arxiv.org/pdf/2009.13276v1

[57]

Advancing the Research and Development of Assured Artificial Intelligence and Machine Learning Capabilities

Tyler J. Shipp, Daniel J. Clouse, Michael J. De Lucia, Metin B. Ahiskali, Kai Steverson, Jonathan M. Mullin, Nathaniel D. Bastian

摘 要:

原 文:http://arxiv.org/pdf/2009.13250v1

[58]

Addressing Class Imbalance in Scene Graph Parsing by Learning to Contrast and Score

He Huang, Shunta Saito, Yuta Kikuchi, Eiichi Matsumoto, Wei Tang, Philip S. Yu

摘 要:

原 文:http://arxiv.org/pdf/2009.13331v1

资 源:github.com/rowanz/neural-motifs, github.com/HCPLab-SYSU/KERN

[59]

RENT -- Repeated Elastic Net Technique for Feature Selection

Anna Jenul, Stefan Schrunner, Kristian Hovde Liland, Ulf Geir Indahl, Cecilia Marie Futsaether, Oliver Tomic

摘 要:

原 文:http://arxiv.org/pdf/2009.12780v1

[60]

BET: A Backtranslation Approach for Easy Data Augmentation in Transformer-based Paraphrase Identification Context

Jean-Philippe Corbeil, Hadi Abdi Ghadivel

摘 要:

原 文:http://arxiv.org/pdf/2009.12452v1

资 源:github.com/jpcorb20/google-translate-backtranslation-da, github.com/jpcorb20/wikipedia-lang-families, github.com/jpcorb20/bet-backtranslation-paraphrase-experiment

[61]

Domain Generalization via Semi-supervised Meta Learning

Hossein Sharifi-Noghabi, Hossein Asghari, Nazanin Mehrasa, Martin Ester

摘 要:

原 文:http://arxiv.org/pdf/2009.12658v1

资 源:github.com/hosseinshn/DGSML

[62]

NITI: Training Integer Neural Networks Using Integer-only Arithmetic

Maolin Wang, Seyedramin Rasoulinezhad, Philip H. W. Leong, Hayden K. H. So

摘 要:

原 文:http://arxiv.org/pdf/2009.13108v1

资 源:github.com/wangmaolin/niti

[63]

Few-shot Object Detection with Self-adaptive Attention Network for Remote Sensing Images

Zixuan Xiao, Wei Xue, Ping Zhong

摘 要:

原 文:http://arxiv.org/pdf/2009.12596v1

[64]

Dynamic aspiration based on Win-Stay-Lose-Learn rule in Spatial Prisoner's Dilemma Gam

Zhenyu Shi, Wei Wei, Xiangnan Feng, Xing Li, Zhiming Zheng

摘 要:

原 文:http://arxiv.org/pdf/2009.12819v1

[65]

Experimental Design for Overparameterized Learning with Application to Single Shot Deep Active Learning

Neta Shoham, Haim Avron

摘 要:

原 文:http://arxiv.org/pdf/2009.12820v1

[66]

QLens: Visual Analytics of Multi-step Problem-solving Behaviors for Improving Question Design

Meng Xia, Reshika Palaniyappan Velumani, Yong Wang, Huamin Qu, Xiaojuan Ma

摘 要:

原 文:http://arxiv.org/pdf/2009.12833v1

[67]

Likelihood Landscape and Local Minima Structures of Gaussian Mixture Models

Yudong Chen, Xumei Xi

摘 要:

原 文:http://arxiv.org/pdf/2009.13040v1

[68]

New Accurate Approximation for Average Error Probability Under $κ-μ$ Shadowed Fading Channel

Yassine Mouchtak, Faissal El Bouanani

摘 要:

原 文:http://arxiv.org/pdf/2009.13159v1

[69]

CASTLE: Regularization via Auxiliary Causal Graph Discovery

Trent Kyono, Yao Zhang, Mihaela van der Schaar

摘 要:

原 文:http://arxiv.org/pdf/2009.13180v1

[70]

Disentangled Neural Architecture Search

Xinyue Zheng, Peng Wang, Qigang Wang, Zhongchao Shi

摘 要:

原 文:http://arxiv.org/pdf/2009.13266v1

[71]

A Large Scale Benchmark and an Inclusion-Based Algorithm for Continuous Collision Detection

Bolun Wang, Zachary Ferguson, Teseo Schneider, Xin Jiang, Marco Attene, Daniele Panozzo

摘 要:

原 文:http://arxiv.org/pdf/2009.13349v1

[72]

RS-MetaNet: Deep meta metric learning for few-shot remote sensing scene classification

Haifeng Li, Zhenqi Cui, Zhiqing Zhu, Li Chen, Jiawei Zhu, Haozhe Huang, Chao Tao

摘 要:

原 文:http://arxiv.org/pdf/2009.13364v1

[73]

Fair Meta-Learning For Few-Shot Classification

Chen Zhao, Changbin Li, Jincheng Li, Feng Chen

摘 要:

原 文:http://arxiv.org/pdf/2009.13516v1

神经网络原理

Neural Network Theory

[74]

TernaryBERT: Distillation-aware Ultra-low Bit BERT

Wei Zhang, Lu Hou, Yichun Yin, Lifeng Shang, Xiao Chen, Xin Jiang, Qun Liu

摘 要:

原 文:http://arxiv.org/pdf/2009.12812v1

[75]

$f$-Divergence Variational Inference

Neng Wan, Dapeng Li, Naira Hovakimyan

摘 要:

原 文:http://arxiv.org/pdf/2009.13093v1

资 源:github.com/yburda/iwae

[76]

Generating End-to-End Adversarial Examples for Malware Classifiers Using Explainability

Ishai Rosenberg, Shai Meir, Jonathan Berrebi, Ilay Gordon, Guillaume Sicard, Eli, David

摘 要:

原 文:http://arxiv.org/pdf/2009.13243v1

[77]

A Derivative-free Method for Quantum Perceptron Training in Multi-layered Neural Networks

Tariq M. Khan, Antonio Robles-Kelly

摘 要:

原 文:http://arxiv.org/pdf/2009.13264v1

[78]

Normalization Techniques in Training DNNs: Methodology, Analysis and Application

Lei Huang, Jie Qin, Yi Zhou, Fan Zhu, Li Liu, Ling Shao

摘 要:

原 文:http://arxiv.org/pdf/2009.12836v1

[79]

Models of Smoothing in Dynamic Networks

Uri Meir, Ami Paz, Gregory Schwartzman

摘 要:

原 文:http://arxiv.org/pdf/2009.13006v1

[80]

RoGAT: a robust GNN combined revised GAT with adjusted graphs

Xianchen Zhou, Hongxia Wang

摘 要:

原 文:http://arxiv.org/pdf/2009.13038v1

[81]

Accelerating Multi-Model Inference by Merging DNNs of Different Weights

Joo Seong Jeong, Soojeong Kim, Gyeong-In Yu, Yunseong Lee, Byung-Gon Chun

摘 要:

原 文:http://arxiv.org/pdf/2009.13062v1

[82]

Distillation of Weighted Automata from Recurrent Neural Networks using a Spectral Approach

Remi Eyraud, Stephane Ayache

摘 要:

原 文:http://arxiv.org/pdf/2009.13101v1

[83]

Why resampling outperforms reweighting for correcting sampling bias

Jing An, Lexing Ying, Yuhua Zhu

摘 要:

原 文:http://arxiv.org/pdf/2009.13447v1

[84]

EIS -- a family of activation functions combining Exponential, ISRU, and Softplus

Koushik Biswas, Sandeep Kumar, Shilpak Banerjee, Ashish Kumar Pandey

摘 要:

原 文:http://arxiv.org/pdf/2009.13501v1

[85]

Learning Deep ReLU Networks Is Fixed-Parameter Tractable

Sitan Chen, Adam R. Klivans, Raghu Meka

摘 要:

原 文:http://arxiv.org/pdf/2009.13512v1

综述

Survey

[86]

A Review of Evolutionary Multi-modal Multi-objective Optimization

Ryoji Tanabe, Hisao Ishibuchi

摘 要:

原 文:http://arxiv.org/pdf/2009.13347v1

资 源:github.com/mikeagn/CEC2013

[87]

Human-Object Interaction Detection:A Quick Survey and Examination of Methods

Trevor Bergstrom, Humphrey Shi

摘 要:

原 文:http://arxiv.org/pdf/2009.12950v1

[88]

Anonymity with Tor: A Survey on Tor Attacks

Ishan Karunanayake, Nadeem Ahmed, Robert Malaney, Rafiqul Islam, Sanjay Jha

摘 要:

原 文:http://arxiv.org/pdf/2009.13018v1

[89]

A Brief Survey and Comparative Study of Recent Development of Pronoun Coreference Resolution

Hongming Zhang, Xinran Zhao, Yangqiu Song

摘 要:

原 文:http://arxiv.org/pdf/2009.12721v1

资 源:github.com/HKUST-KnowComp/PCR

[90]

Deep Learning for Predictive Business Process Monitoring: Review and Benchmark

Efrén Rama-Maneiro, Juan C. Vidal, Manuel Lama

摘 要:

原 文:http://arxiv.org/pdf/2009.13251v1

资 源:github.com/thaihungle/MAED, github.com/Julian-Theis/PyDREAM, github.com/Julian-Theis/DREAM-NAP, github.com/mhinkka/articles, github.com/nicoladimauro/nnpm

[91]

Automatic Arabic Dialect Identification Systems for Written Texts: A Survey

Maha J. Althobaiti

摘 要:

原 文:http://arxiv.org/pdf/2009.12622v1

[92]

Machine Learning in Event-Triggered Control: Recent Advances and Open Issues

Leila Sedghi, Zohaib Ijaz, Md. Noor-A-Rahim, Kritchai Witheephanich, Dirk Pesch

摘 要:

原 文:http://arxiv.org/pdf/2009.12783v1

[93]

A Survey on Deep Learning Methods for Semantic Image Segmentation in Real-Time

Georgios Takos

摘 要:

原 文:http://arxiv.org/pdf/2009.12942v1

[94]

Medical Image Segmentation Using Deep Learning: A Survey

Tao Lei, Risheng Wang, Yong Wan, Xiaogang Du, Hongying Meng, Asoke K. Nandi

摘 要:

原 文:http://arxiv.org/pdf/2009.13120v1

[95]

Landscape of R packages for eXplainable Artificial Intelligence

Szymon Maksymiuk, Alicja Gosiewska, Przemyslaw Biecek

摘 要:

原 文:http://arxiv.org/pdf/2009.13248v1

[96]

The Elements of End-to-end Deep Face Recognition: A Survey of Recent Advances

Hang Du, Hailin Shi, Dan Zeng, Tao Mei

摘 要:

原 文:http://arxiv.org/pdf/2009.13290v1

平台与工具

Platform & Tool

[97]

BOML: A Modularized Bilevel Optimization Library in Python for Meta Learning

Yaohua Liu, Risheng Liu

摘 要:

原 文:http://arxiv.org/pdf/2009.13357v1

资 源:github.com/dut-media-lab/BOML, github.com/alshedivat/meta-blocks, github.com/lucfra/FAR-HO

[98]

The Development of Visualization Psychology Analysis Tools to Account for Trust

Rita Borgo, Darren J Edwards

摘 要:

原 文:http://arxiv.org/pdf/2009.13200v1

[99]

Extendible and Efficient Python Framework for Solving Evolution Equations with Stabilized Discontinuous Galerkin Method

Andreas Dedner, Robert Klöfkorn

摘 要:

原 文:http://arxiv.org/pdf/2009.13416v1

语音技术

Audio & Speech

[100]

Siamese Capsule Network for End-to-End Speaker Recognition In The Wild

Amirhossein Hajavi, Ali Etemad

摘 要:

原 文:http://arxiv.org/pdf/2009.13480v1

[101]

PIN: A Novel Parallel Interactive Network for Spoken Language Understanding

Peilin Zhou, Zhiqi Huang, Fenglin Liu, Yuexian Zou

摘 要:

原 文:http://arxiv.org/pdf/2009.13431v1

知识图谱

Knowledge Graph

[102]

$ε$-net Induced Lazy Witness Complexes on Graphs

Naheed Anjum Arafat, Debabrota Basu, Stéphane Bressan

摘 要:

原 文:http://arxiv.org/pdf/2009.13071v1

[103]

Graph Adversarial Networks: Protecting Information against Adversarial Attacks

Peiyuan Liao, Han Zhao, Keyulu Xu, Tommi Jaakkola, Geoffrey Gordon, Stefanie Jegelka, Ruslan Salakhutdinov

摘 要:

原 文:http://arxiv.org/pdf/2009.13504v1

资 源:github.com/kimiyoung/planetoid, github.com/cmoon2/knowledge_graph, github.com/TimDettmers/ConvE, github.com/liaopeiyuan/GAL

[104]

QuatRE: Relation-Aware Quaternions for Knowledge Graph Embeddings

Dai Quoc Nguyen, Thanh Vu, Tu Dinh Nguyen, Dinh Phung

摘 要:

原 文:http://arxiv.org/pdf/2009.12517v1

[105]

Inductively Representing Out-of-Knowledge-Graph Entities by Optimal Estimation Under Translational Assumptions

Damai Dai, Hua Zheng, Fuli Luo, Pengcheng Yang, Baobao Chang, Zhifang Sui

摘 要:

原 文:http://arxiv.org/pdf/2009.12765v1

[106]

Multi-scale Receptive Fields Graph Attention Network for Point Cloud Classification

Xi-An Li, Lei Zhang, Li-Yan Wang, Jian Lu

摘 要:

原 文:http://arxiv.org/pdf/2009.13289v1

强化学习

Reinforcement Learning

[107]

Sim-to-Real Transfer in Deep Reinforcement Learning for Robotics: a Survey

Wenshuai Zhao, Jorge Peña Queralta, Tomi Westerlund

摘 要:

原 文:http://arxiv.org/pdf/2009.13303v1

[108]

Towards Heterogeneous Multi-Agent Reinforcement Learning with Graph Neural Networks

Douglas De Rizzo Meneghetti, Reinaldo Augusto da Costa Bianchi

摘 要:

原 文:http://arxiv.org/pdf/2009.13161v1

[109]

Deep Reinforcement Learning for Process Synthesis

Laurence Illing Midgley

摘 要:

原 文:http://arxiv.org/pdf/2009.13265v1

[110]

Avoiding Help Avoidance: Using Interface Design Changes to Promote Unsolicited Hint Usage in an Intelligent Tutor

Mehak Maniktala, Christa Cody, Tiffany Barnes, Min Chi

摘 要:

原 文:http://arxiv.org/pdf/2009.13371v1

[111]

Is Reinforcement Learning More Difficult Than Bandits? A Near-optimal Algorithm Escaping the Curse of Horizon

Zihan Zhang, Xiangyang Ji, Simon S. Du

摘 要:

原 文:http://arxiv.org/pdf/2009.13503v1

推荐系统

Recommendation System

[112]

Simultaneous Relevance and Diversity: A New Recommendation Inference Approach

Yifang Liu, Zhentao Xu, Qiyuan An, Yang Yi, Yanzhi Wang, Trevor Hastie

摘 要:

原 文:http://arxiv.org/pdf/2009.12969v1

[113]

RecoBERT: A Catalog Language Model for Text-Based Recommendations

Itzik Malkiel, Oren Barkan, Avi Caciularu, Noam Razin, Ori Katz, Noam Koenigstein

摘 要:

原 文:http://arxiv.org/pdf/2009.13292v1

[114]

Virtual Proximity Citation (VCP): A Supervised Deep Learning Method to Relate Uncited Papers On Grounds of Citation Proximity

Rohit Rawat

摘 要:

原 文:http://arxiv.org/pdf/2009.13294v1

[115]

CAT STREET: Chronicle Archive of Tokyo Street-fashion

Satoshi Takahashi, Keiko Yamaguchi, Asuka Watanabe

摘 要:

原 文:http://arxiv.org/pdf/2009.13395v1

医疗与健康

Medical Science & Health Care

[116]

What Disease does this Patient Have? A Large-scale Open Domain Question Answering Dataset from Medical Exams

Di Jin, Eileen Pan, Nassim Oufattole, Wei-Hung Weng, Hanyi Fang, Peter Szolovits

摘 要:

原 文:http://arxiv.org/pdf/2009.13081v1

[117]

Domain Generalization for Medical Imaging Classification with Linear-Dependency Regularization

Haoliang Li, YuFei Wang, Renjie Wan, Shiqi Wang, Tie-Qiang Li, Alex C. Kot

摘 要:

原 文:http://arxiv.org/pdf/2009.12829v1

资 源:github.com/wyf0912/LDDG

[118]

BiteNet: Bidirectional Temporal Encoder Network to Predict Medical Outcomes

Xueping Peng, Guodong Long, Tao Shen, Sen Wang, Jing Jiang, Chengqi Zhang

摘 要:

原 文:http://arxiv.org/pdf/2009.13252v1

资 源:github.com/Xueping/BiteNet

[119]

Hierarchical Deep Multi-modal Network for Medical Visual Question Answering

Deepak Gupta, Swati Suman, Asif Ekbal

摘 要:

原 文:http://arxiv.org/pdf/2009.12770v1

资 源:github.com/keras-team/keras, github.com/youngzhou97qz/CLEF2018-VQA-Med

[120]

Visual Exploration and Knowledge Discovery from Biomedical Dark Data

Shashwat Aggarwal, Ramesh Singh

摘 要:

原 文:http://arxiv.org/pdf/2009.13059v1

应用

Application

[121]

Weakly Supervised Deep Functional Map for Shape Matching

Abhishek Sharma, Maks Ovsjanikov

摘 要:

原 文:http://arxiv.org/pdf/2009.13339v1

[122]

Mitigating Gender Bias for Neural Dialogue Generation with Adversarial Learning

Haochen Liu, Wentao Wang, Yiqi Wang, Hui Liu, Zitao Liu, Jiliang Tang

摘 要:

原 文:http://arxiv.org/pdf/2009.13028v1

[123]

Trainable Structure Tensors for Autonomous Baggage Threat Detection Under Extreme Occlusion

Taimur Hassan, Samet Akcay, Mohammed Bennamoun, Salman Khan, Naoufel Werghi

摘 要:

原 文:http://arxiv.org/pdf/2009.13158v1

[124]

Balancing thermal comfort datasets: We GAN, but should we?

Matias Quintana, Stefano Schiavon, Kwok Wai Tham, Clayton Miller

摘 要:

原 文:http://arxiv.org/pdf/2009.13154v1

资 源:github.com/buds-lab/comfortGAN

[125]

Learning to Match Jobs with Resumes from Sparse Interaction Data using Multi-View Co-Teaching Network

Shuqing Bian, Xu Chen, Wayne Xin Zhao, Kun Zhou, Yupeng Hou, Yang Song, Tao Zhang, Ji-Rong Wen

摘 要:

原 文:http://arxiv.org/pdf/2009.13299v1

资 源:github.com/huggingface/transformers

[126]

How do people describe locations during a natural disaster: an analysis of tweets from Hurricane Harvey

Yingjie Hu, Jimin Wang

摘 要:

原 文:http://arxiv.org/pdf/2009.12914v1

资 源:github.com/geoai-lab/HowDoPeopleDescribeLocations

[127]

Semi-Supervised Learning for In-Game Expert-Level Music-to-Dance Translation

Yinglin Duan, Tianyang Shi, Zhengxia Zou, Jia Qin, Yifei Zhao, Yi Yuan, Jie Hou, Xiang Wen, Changjie Fan

摘 要:

原 文:http://arxiv.org/pdf/2009.12763v1

[128]

Lightweight assistive technology: A wearable, optical-fiber gesture recognition system

Sanjay Seshan

摘 要:

原 文:http://arxiv.org/pdf/2009.13322v1

工程化

Engineering

[129]

Universal Physiological Representation Learning with Soft-Disentangled Rateless Autoencoders

Mo Han, Ozan Ozdenizci, Toshiaki Koike-Akino, Ye Wang, Deniz Erdogmus

摘 要: